En la conferencia SC23 en Denver, NVIDIA La actuación fue revelada por primera vez. Blackwell P100una GPU que llegará en 2024 y que sucederá a la generación Hopper (H100 y H200).

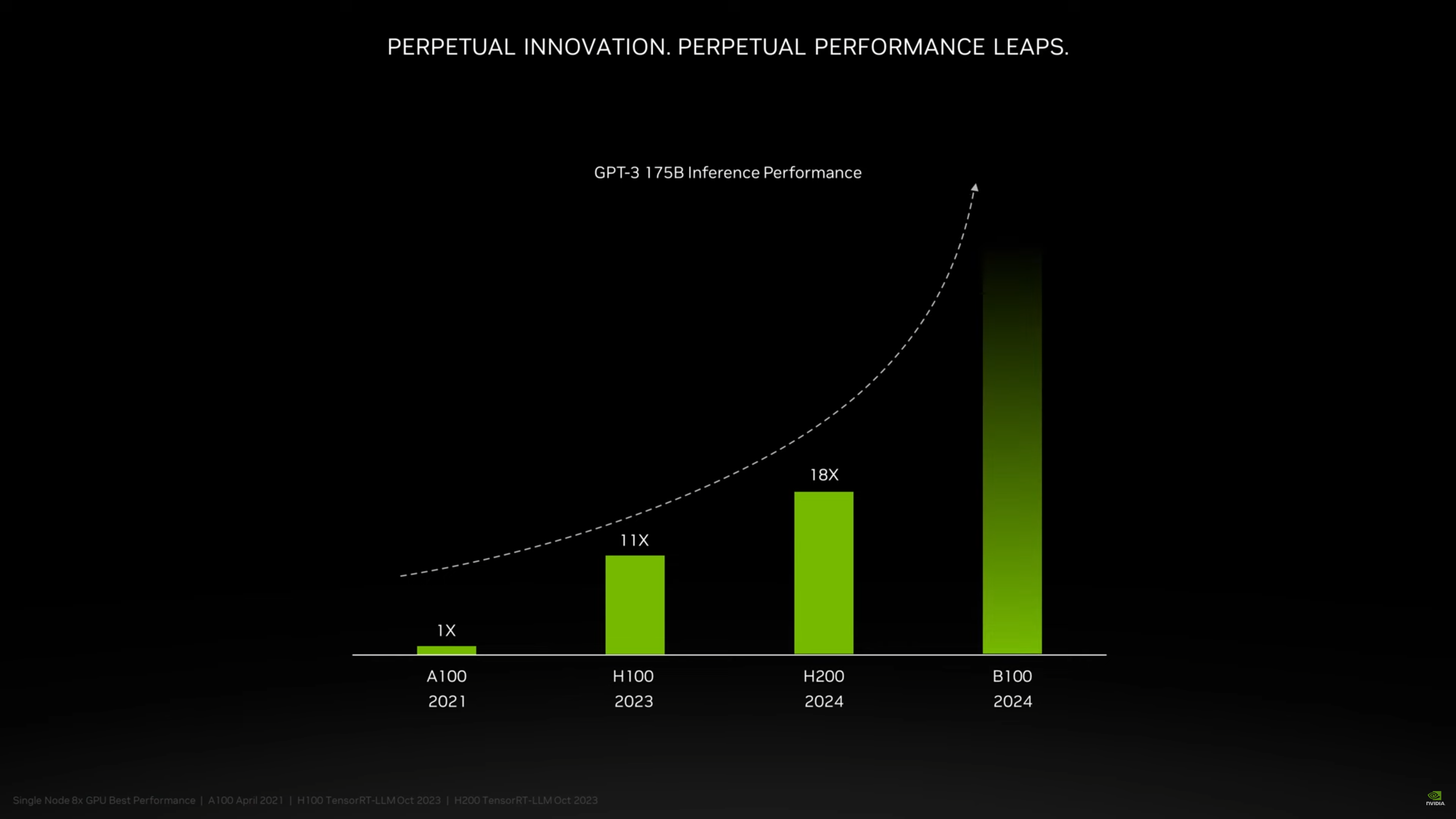

En una breve diapositiva de vista previa, NVIDIA mostró esto El Blackwell B100 podrá quemar su actual solución insignia H200. No hay escala para el eje vertical, pero puedes adivinar fácilmente que realizar inferencia Con modelos GPT-3 como GPT-3 175B (rebautizado como Da Vinci, 175 mil millones de parámetros) Más del doble gracias a la nueva arquitectura. Evidentemente, los datos deben tomarse como una proyección única y no como un valor general.

Click para agrandar

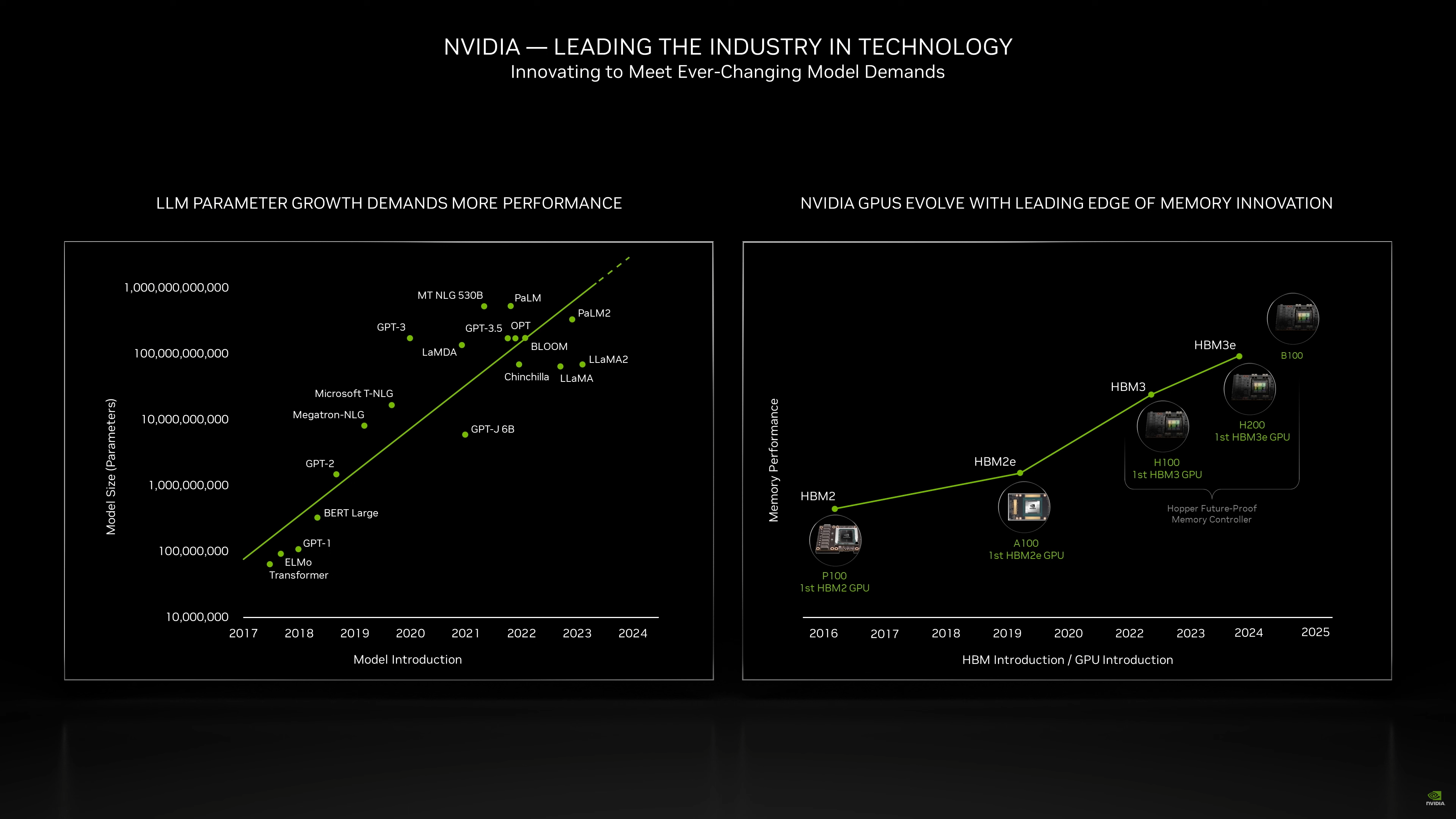

Según los rumores, NVIDIA utilizará el proceso de producción de 3 nm de TSMC para crear el Blackwell B100: también es posible que este sea el primer proyecto MCM (módulo multichip, múltiples chips en un paquete que funcionan juntos) de la compañía. Segunda porción Parece indicar que el B100 vendrá acompañado de memoria HBM3EQuizás más rápido que el aplicado al H200.

Click para agrandar

La compañía estadounidense anunció recientemente el paso de un ritmo bienal a uno anual en el desarrollo de nuevas arquitecturas para el mundo de los centros de datos.

NVIDIA: Antes del B100, aquí está el H200 con 141 GB de memoria HBM3E

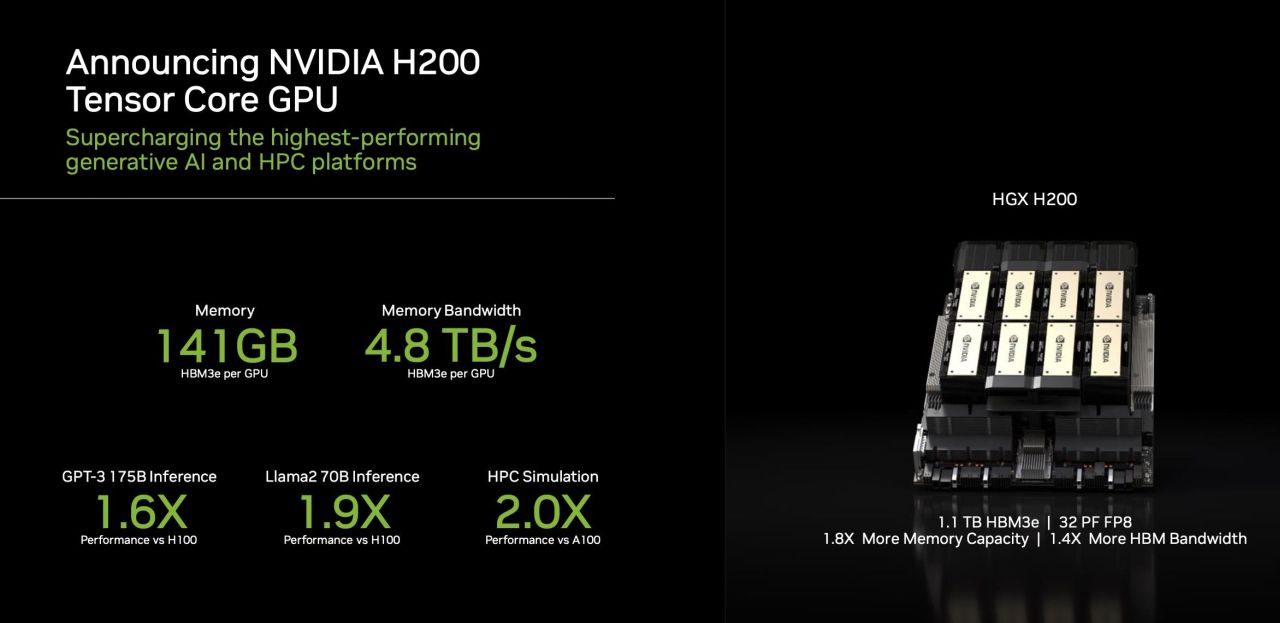

En agosto, NVIDIA anunció el Superchip Grace Hopper GH200, una versión del Superchip Grace Hopper (CPU ARM + GPU Hopper) equipada con memoria HBM3E. En estas horas se relanzó la empresa bajo el liderazgo de Jensen Huang H200, una versión actualizada con memoria HBM3E del acelerador basado en GPU H100. No sólo eso, sino que la capacidad de la memoria oscila entre 80 y 141GBcon ancho de banda 4,8 Tbps gracias a un bus de 6144 bits.

Click para agrandar

El número 141 es especial y, de hecho, hay 144 GB en la tarjeta como resultado de seis pilas de 24 GB, pero NVIDIA decidió mantener el margen por alguna razón, tal vez tenga que ver con el rendimiento de producción.

Aunque NVIDIA no entró en detalles, La GPU no parece haber sufrido ningún cambio respecto al H200Por lo tanto, las mejoras de rendimiento citadas por la empresa deben estar relacionadas únicamente con la memoria. La nueva aceleradora estará disponible en el segundo trimestre de 2024.

Click para agrandar

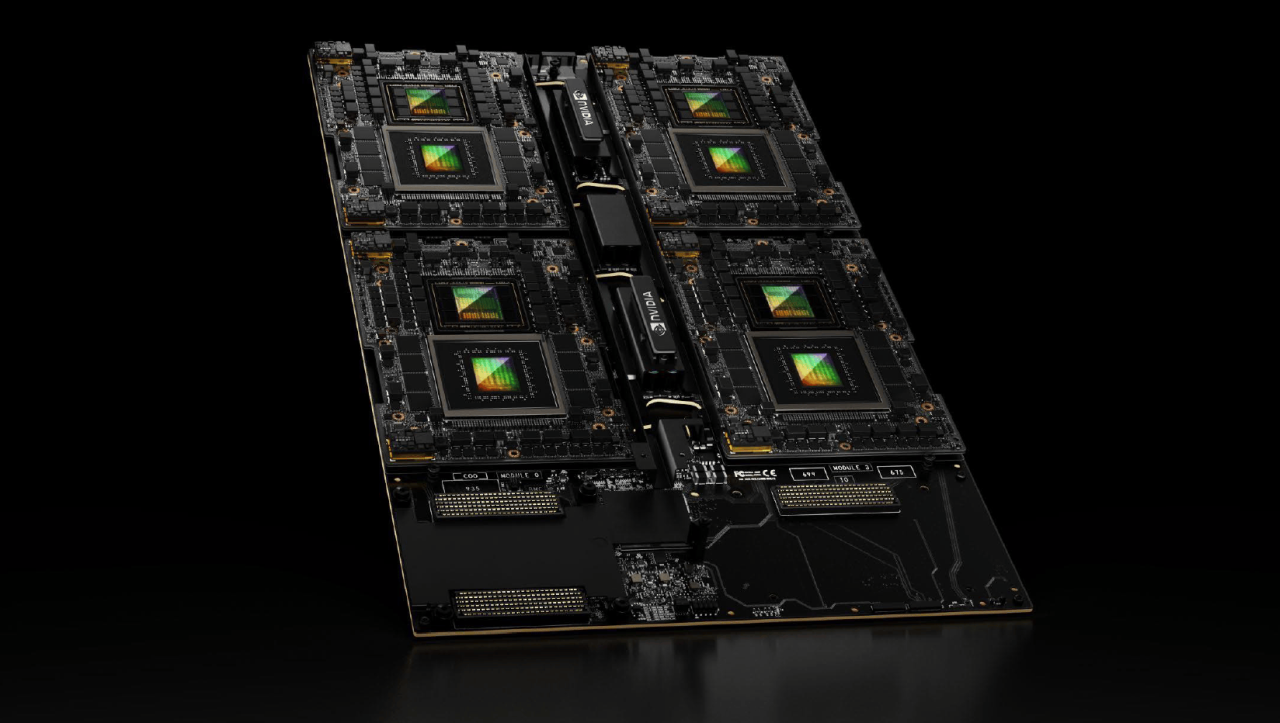

NVIDIA también reveló HGX H200, es decir, un sistema que contiene 8 soluciones H200 en formato SMX,Actualización del HGX H100 preexistente. Finalmente, se pide otra novedad. Cuádruple GH200: Como sugiere el nombre, es una solución que combina 4 soluciones GH200 Grace Hopper Superchip en paralelo, para un total 288 núcleos ARM, memoria LPDDR5X de 1920 GB, memoria HBM3 de 384 GB (En este caso no hablamos de la versión actualizada con HBM3E), con un total de 2,3TB de memoria. Entre las primeras empresas en ofrecer esta solución encontramos: Como se indica aquíHPE (HP Enterprise) con Cray EX2500.

«Alcohol ninja. Orgulloso especialista en tocino. Organizador. Creador aficionado. Solucionador de problemas amigable con los hipster. Gurú de la comida. Alborotador. Experto en Twitter».